Le programme d’intelligence artificielle GPT-2 est capable d’écrire de faux articles de presse. À l’heure des infox (fake news), il représente un danger, et ses concepteurs ont décidé de ne pas le rendre public.

au sommaire

Les « fake news » sont devenues la hantise des démocraties par leur viralité sur les réseaux sociauxréseaux sociaux, et des projets de lois apparaissent même pour contrer ce phénomène si dangereux, capable de manipuler les massesmasses. C'est pour cette raison que GPT-2 restera confidentiel et ne sera pas mis à disposition du public et des entreprises.

Mis au point par OpenAI, une société de recherche en intelligence artificielle à but non lucratif soutenue par Elon MuskElon Musk, il s'agit d'un générateurgénérateur de texte. Mais il ne s'agit pas de simples textes, mais carrément de reportages, d'articles de presse et même de fictions ! Jusque-là, c'est très bien... sauf que la machine est si performante qu'elle est capable de créer des « deepfakes for text », soit des fausses informations plus que crédibles créées par une intelligence artificielle, et même de les partager elle-même sur les réseaux sociaux !

Avec structure et style

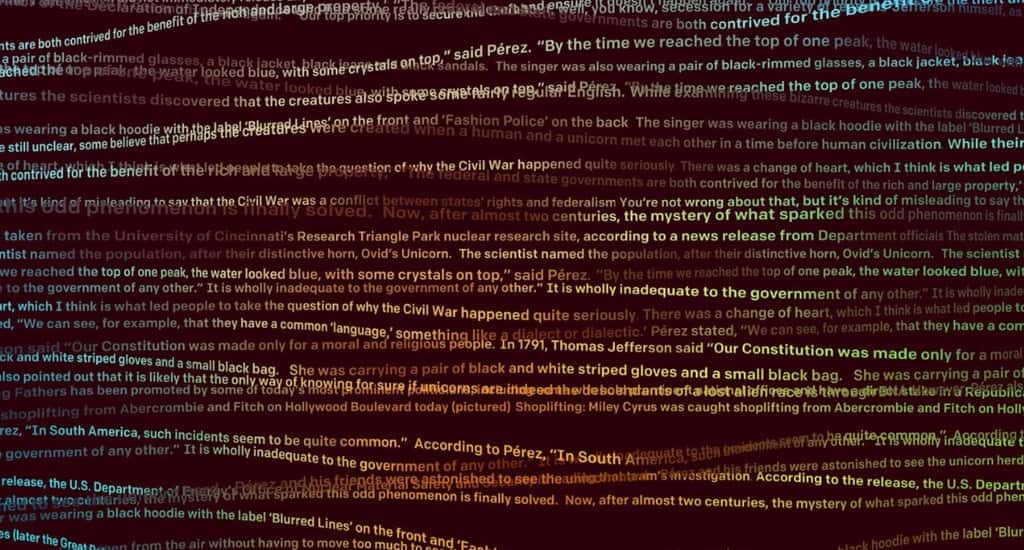

C'est justement parce que leur machine est parvenue à créer des articles criants de vérité que les chercheurs ont décidé de la garder dans les cartons, et de ne pas la partager. Au départ, le système d'intelligence artificielle recueille des textes, et ça varie de quelques mots à une dizaine de lignes. Ensuite, les chercheurs proposent à leur programme de générer la suite ou carrément de créer son propre article. Et c'est là que la machine les a bluffés car elle est capable de conserver le stylestyle d'un texte, mais aussi de le structurer, effaçant ainsi le caractère automatique et mot à mot des premiers générateurs de texte.

En conséquence, les chercheurs ont choisi de freiner le développement de la machine pour éviter qu'elle ne tombe dans les mains de personnes malveillantes. « Nous devons effectuer des expériences pour découvrir ce qu'ils peuvent et ne peuvent pas faire », explique ainsi Jack Clark, au Guardian, à propos de l'utilisation malveillante de GPT-2. « Si on ne peut pas anticiper toutes les possibilités d'un modèle, on doit en revanche être capable de voir ce qu'il peut faire. Il y a des personnes bien plus au fait que nous pour imaginer ce qu'elles peuvent faire de malveillant avec. »